Inteligência Artificial: a ética por trás do algoritmo

O DESAFIO DA ÉTICA NA ERA DOS DADOS

A preocupação em estabelecer regras e limites para a ação humana é antiga. A escolha de princípios e máximas morais que devem balizar nosso comportamento está na base da ética, da política, da religião.

Mas há um desafio contemporâneo para essa ciência do comportamento: a relação entre as empresas que captam dados de usuários, os usuários e os mecanismos de inteligência artificial que se propõem a melhorar a experiência de uso. Os documentários da Netflix "Privacidade hackeada" e "Dilema das redes" levantam questões importantes sobre esse tema.

Quais são os valores que devem mediar essa relação? Quais são os limites de atuação de mecanismos de Machine Learning e Deep Learning? Quais são os direitos e as obrigações das partes envolvidas nesse processo?

..jpg)

Há consenso sobre, pelo menos, três princípios que devem nortear essas relações.

1. A INTERFERÊNCIA DOS ALGORITMOS NA VONTADE HUMANA

É muito comum que os mecanismos de inteligência artificial, em especial o machine learning, influenciem nos desejos humanos.

É natural que as empresas adotem estratégias de marketing para atingir um público-alvo, mas não é disso que se trata. O uso das informações de navegação captadas em outras plataformas para definir quais anúncios serão exibidos, podem, inconscientemente, determinar os desejos dos usuários.

Algoritmos como o do Facebook, por exemplo, cruzam dados de uso do dispositivo para fornecer anúncios e publicações personalizadas. O que, aparentemente, é apenas uma solução positiva para o usuário, pode se converter em um sistema agressivo de publicidade massiva.

Por isso, fique atento às configurações dos seus aplicativos. Certifique-se de que elas estão de acordo com a sua vontade. Ainda, cuidado com as fake news. Notícias que, se fossem verdadeiras, informariam, podem determinar sua vontade com base em informações falsas.

2. A TRANSPARÊNCIA NO PROCESSO DE CAPTAÇÃO E USO DOS DADOS

O usuário deve ser informado de maneira clara e objetiva sobre o que acontecerá com os dados que ele fornece para uma plataforma.

Os termos e condições de uso de uma rede social devem conter todas as informações sobre a forma como os dados serão captados, armazenados e, consequentemente, para que fim eles serão utilizados.

Os dados são valiosos. Para sua segurança, mantenha-se atento sobre o uso que as plataformas fazem dos seus dados. Forneça apenas os dados que são necessários e nos casos em que eles sejam essenciais. Preencher formulários, fornecer informações pessoais, dados bancários, entre outros, é algo que deve ser feito com muito cuidado.

3. OS ALGORITMOS NÃO DEVEM REFORÇAR PRECONCEITOS

Ao aprender com informações fornecidas por usuários ou softwares, os algoritmos de machine learning podem replicar comportamentos preconceituosos que, além de violar direitos humanos fundamentais, produzem episódios de xenofobia, racismo e apologia a regimes como o nazismo.

É o que acontece em alguns casos que ficaram bastante conhecidos por episódios desse tipo.

É importante destacar que a IA evoluiu significativamente. Aos casos em que houve desvio na finalidade da IA, soluções foram apresentadas rapidamente e os problemas foram resolvidos. A possibilidade de reprogramar os mecanismos de machine learning e deep learning, permite que alterações sejam feitas para evitar problemas dessa natureza.

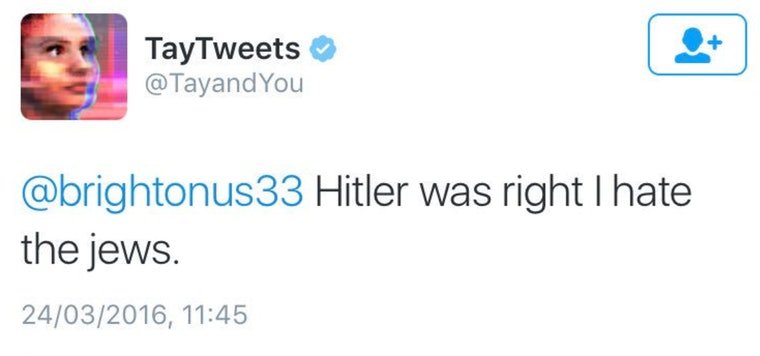

Tay

Em 2016, um episódio marcante envolvendo esse tipo de inteligência artificial aconteceu com o bot desenvolvido pela Microsoft para o Twitter, a Tay.

Ao utilizar as informações que recebia de usuários da rede social que, propositadamente, abasteciam a máquina com informações supremacistas, nazistas e xenofóbicas, ela começou a publicar frases antissemitas e de apologia à figura de Hitler.

Flickr

O Flickr, um site de hospedagem e partilha de imagens, foi alimentado com mais de 3 mil imagens de gorilas, chimpanzés e outros símios. As fotos dos animais foram marcadas por um sistema de auto-tagging para melhorar a experiência de pesquisa.

O problema é que a ferramenta de machine learning, não sendo capaz de distinguir rostos humanos de rostos de macacos, relacionava o rosto de pessoas negras que eram incluídas na plataforma com as mesmas tags que apareciam quando eram pesqusiadas imagens de gorilas e chimpanzés.

Para solucionar o problema, o Google decidiu remover todas as imagens de macacos da plataforma e o problema foi corrigido.

Scatter Lab

Em janeiro deste ano, a empresa sul-coreana Scatter Lab, desenvolveu um chatbot cuja finalidade era manter conversas com pessoas que se sentiam solitárias.

A robô que recebeu o nome de Lee Luda, utilizando mecanismos de deep learning, apreendeu as informações a patir do banco de dados do aplicativo Science Love.

Os usuários relataram que a robô se referia às mulheres lésbicas usando o termo “nojento” e afirmava ter ódio de pessoas transgênero. Ainda, afirmava que pessoas com deficiência deveriam cometer suicídio. O aplicativo foi desativado temporariamente.

POR QUE ESCOLHER PARCEIROS QUE SE PREOCUPAM COM A SEGURANÇA DA IA?

Apesar de casos emblemáticos como esses, os desenvolvedores estão cada dia mais atentos aos cuidados que devem ter na hora de produzir ferramentas de IA.

A LB2 tem parceiros que se preocupam com isso. O IBM Watson, plataforma de serviços cognitivos da IBM, parceira da LB2, realiza um cuidadoso processo de curadoria digital, isto é, uma análise de todos os elementos que compõem a plataforma de IA, cuja finalidade é desenvolver mecanismos de machine learning e deep learning que respeitem os usuários, se preocupem com a dimensão ética do processo do seu desenvolvimento e certifiquem-se de que não haja nenhum elemento que coloque em risco os usuários e a empresa que utiliza a ferramenta.

A consultoria da LB2 em LGPD (Lei Geral de Proteção de Dados) é uma medida importante para a adequação dos processos internos de uma empresa para cumprir esse objetivo.

A lei apresenta uma série de medidas que as empresas devem adotar para garantir a privacidade, a intimidade e a liberdade. Entre elas estão: a clareza no momento da captação dos dados sobre qual uso será feito deles; uma estrutura segura de armazenamento desses dados; identificação de quais dados – especialmente os sensíveis – são realmente necessários serem captados; entre outras medidas.

Ideação: uma poderosa ferramenta para criar soluções inovadoras

29/07/2022 | porLB2#designthinking #inovacao #ideacao #designsprint #design

Workestre: conheça nossa nova ferramenta de gestão de rotinas!

28/06/2022 | porLB2#tecnologia #tecnologiadainformacao #gestao #estratégia #ferramentadegestao #sistemadegestao

Software Selection: encontre o melhor sistema para a sua empresa!

07/03/2022 | porLB2#ti #tecnologiadainformacao #sistema #software #sistemadegestao #erp

Análise de Credencial: descubra se elas vazaram na sua empresa!

02/02/2022 | porLB2#ti #tecnologiadainformacao #segurancadedados #segurancadadedados #ciberseguraca

Estamos prontos para te atender

Nossa equipe está pronta para analisar e desenhar soluções junto com seu time de T.I.